本文共 5109 字,大约阅读时间需要 17 分钟。

作者:箫疯

__阿里安全图灵实验室今年参加了ECCV2018 “First Workshop on Computer Vision For Fashion, Art and Design” 并在时尚生成竞赛中获得了冠军,已受邀在研讨会上演讲展示。另外在ECCV2018 “2nd Workshop on Youtube-8M Large-Scale Video Understanding” 上我们团队也收获成果,发表了workshop文章 “Hierarchical Video Frame Sequence Representation with Deep Convolutional Graph Network”。

我们通过此文详细介绍时尚生成竞赛中用到的技术方案。__背景

作为现代文化和经济中举足轻重的一个组成部分,创意产业不断丰富着我们的生活,在时尚、艺术和设计等领域的创作日新月异。人工智能和计算机视觉等技术也给创意产业带来了新的玩法,用算法来辅助、理解和保护创意日益受到学术界和工业界的重视。

今年举办的计算机视觉领域顶级会议ECCV召开了首届"时尚、艺术和设计中的计算机视觉"研讨会,来讨论时尚和创意视觉内容生成的计算机视觉领域的一些开放性问题,并举办了首届"时尚图像生成"国际竞赛。举办方提供了一个包含数十万时尚图像和对应文本描述的FashionGen数据集,而竞赛任务则是根据给定文本直接生成对应的图像。评估标准包括两部分,对生成图像的质量进行Inception网络的客观评分,和对文本和图像在语义层面的匹配度进行人工打分并汇总给出的主观评分。

图1 workshop主页及竞赛数据集示例 阿里安全旗下的图灵实验室(ATL)在两项评分中均荣获第一名,并受邀在研讨会上演讲展示。

图1 workshop主页及竞赛数据集示例 阿里安全旗下的图灵实验室(ATL)在两项评分中均荣获第一名,并受邀在研讨会上演讲展示。 时尚图像生成

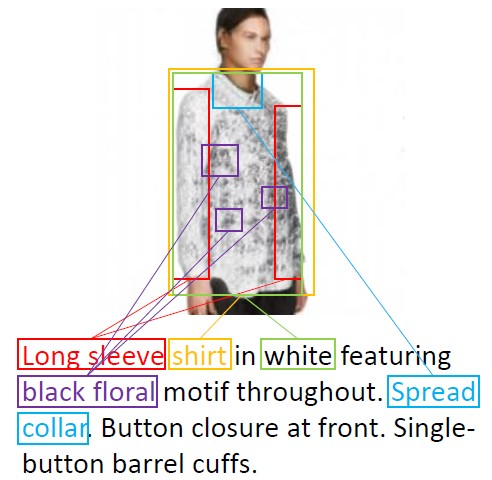

我们方法基于细粒度的跨模态注意力,主要思路是将不同模态的数据(文本、图像)映射到同一特征空间中计算相似度,从而学习文本中每个单词语义和图像局部区域特征的对应关系,辅助生成符合文本描述的细粒度时尚图像,如图2所示。

图2 不同单词描述图像不同区域示例

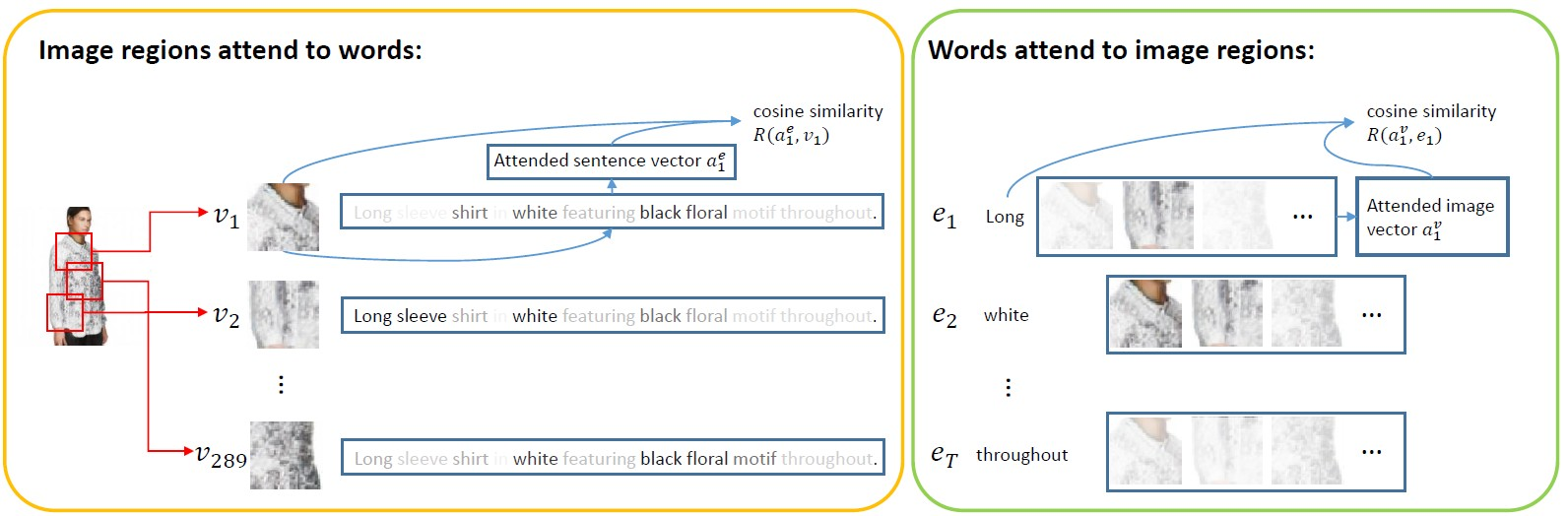

传统的基于文本的图像生成方法通常只学习句子和图像整体的语义关联,缺乏对服装细节纹理或设计的建模。为了改进这一问题,我们引入了跨模态注意力机制。如图3左边区域,已知图像的局部特征,可以计算句子中不同单词对区域特征的重要性,而句子语义可以视为基于重要性权重的动态表示。跨模态注意力可以将图片与文字的语义关联在更加精细的局部特征层级上建模,有益于细粒度时尚图像的生成。

图3 跨模态注意力机制,左图表示通过图像局部特征计算不同单词的重要性,右图表示通过词向量计算不同图像局部特征的重要性

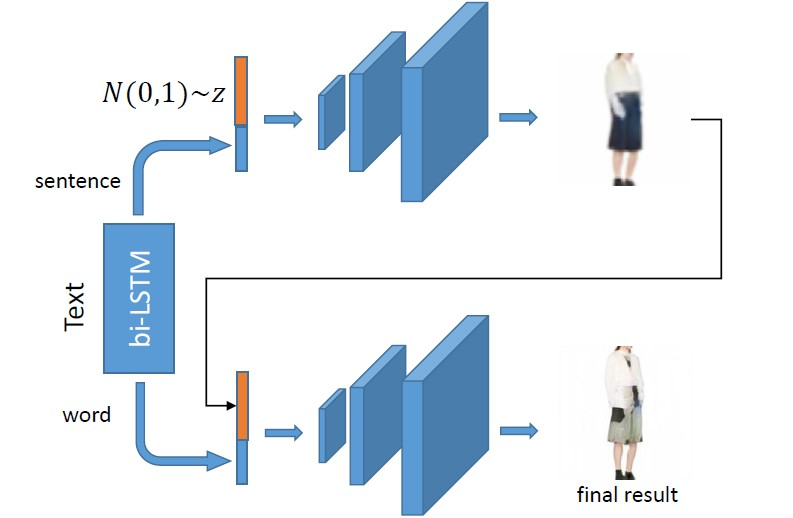

我们用bi-LSTM作为文本编码器,GAN作为对抗生成模型,并将生成过程分为由粗到精,逐步增加分辨率的两个阶段:

第一阶段利用句子的整体语义和随机输入学习图像在大尺度上的整体结构。第二阶段利用单词层级的语义在第一阶段低分辨率输出上做局部细节的修正和渲染,得到细粒度的高分辨率时尚图像输出。

图4 整体框架概览。顶部分支利用文本整体语义学习低分辨率的图像大致结构,底部分支在上一阶段的输出上做图像细节的修正,生成更加细粒度的时尚设计或纹理

对抗生成网络

传统的生成式对抗网络由判别器和生成器两部分组成,判别器的目标是判别生成图像是否在真实数据集的分布中,而生成器的目标是尽可能的骗过判别器生成逼近真实数据集的图像,通过两者的迭代更新,最终达到理论上的纳什均衡点。这个过程被称为对抗训练,对抗训练的提出为建立图像等复杂数据分布建立了可能性。

对于文本生成图像的任务,需要更改生成器的输入以及目标函数,我们将两个阶段的生成器分别设为$ G_{1} $和$ G_{2} $,整个流程可被形式化为:

$$ h_{1} = G_{1}(z, \overline{e}) \\ \hat{x} = G_{2}(h_{1}, e) $$

其中$ \overline{e} \in \mathbb{R}^{D} $是句子向量,$D$为双向LSTM两个方向上输出的维度和,$ e \in \mathbb{R}^{D \times T} $是词向量矩阵,$T$指代单词的个数,$h_{1}$表示第一阶段激活值输出,$\hat{x}$表示生成的图像。

我们需要优化的目标函数定义为:$$ \mathcal{L} = \mathcal{L}_{G_{1}} + \mathcal{L}_{G_{2}} + \mathcal{L}_{similarity} $$

其中$\mathcal{L}_{G_{\ast}}$是对抗损失,$\mathcal{L}_{similarity}$是生成图像和对应描述的相似性损失,$\mathcal{L}_{G_{1}}$由两部分组成:

$$ \mathcal{L}_{G_{1}} = -\frac{1}{2}\mathbb{E}_{\hat{x}\sim p_{G_{1}}}\left [ \log (D_{1}(\hat{x})) \right ]-\frac{1}{2}\mathbb{E}_{\hat{x}\sim p_{G_{1}}}\left [ \log (D_{1}(\hat{x},\overline{e})) \right ] $$

其中第一项非条件损失表示图像本身的真伪,第二项条件损失表示图像和句子语义是否匹配。对$ \mathcal{L}_{G_{2}} $也同理。

判别器$ D_{1} $,$D_{2}$同时也被训练以最小化交叉熵损失:$$ \mathcal{L}_{D_{1}} = -\frac{1}{2}\mathbb{E}_{\hat{x}\sim p_{data_{1}}}\left [ \log (D_{1}(\hat{x})) \right ]-\frac{1}{2}\mathbb{E}_{\hat{x}\sim p_{G_{1}}}\left [ \log (1-D_{1}(\hat{x})) \right ] \\ -\frac{1}{2}\mathbb{E}_{\hat{x}\sim p_{data_{1}}}\left [ \log (D_{1}(\hat{x},\overline{e})) \right ]-\frac{1}{2}\mathbb{E}_{\hat{x}\sim p_{G_{1}}}\left [ \log (1-D_{1}(\hat{x},\overline{e})) \right ] $$

该项对对$ \mathcal{L}_{D_{2}} $也同理。

基于跨模态注意力的相似性

本节将详细介绍在我们的方法中用到的跨模态注意力机制,给出图像-文本对<$V$, $E$>,我们取Inceptionv3中"mixed 6e”层的输出($768\times17\times17$)作为图像区域特征,我们将空间维度展平得到$768\times289$,"average pooling"层的输出($2048$)作为图像全局特征,对这些特征使用投影矩阵$W \in \mathbb{R}^{D\times768}$和$\overline{W} \in \mathbb{R}^{D\times2048}$变换到$v \in \mathbb{R}^{D\times289}$和$\overline{v} \in \mathbb{R}^{D}$

由此,可以得到相似度矩阵:$$ s = e^{T}v \in \mathbb{R}^{T\times289} $$

其中元素$s_{i,j}$代表了第$i$个单词和第$j$个子区域的点积相似性

- 图像-文本相似性对于第$i$个单词,我们最终可以建立不同区域特征的加权和(越相似赋予越大的权重):

$$ a_{i} = \sum_{j=1}^{289}v_{j}s_{i,j} $$

其中$a_{i} \in \mathbb{R}^{D}$是对应于第$i$个单词,图像特征的动态表述。

对第$i$个单词,求得$a_{i}$和$e_{i}$的余弦相似度$R(a_{i},e_{i}) = \frac{a_{i}^{T}e_{i}}{\left \| a_{i} \right \|\left \| e_{i} \right \|}$,综合可得图片对<$V$, $E$>的相似度为:$$ R(E,V) = \log (\sum_{i=1}^{T}\exp (\gamma R(a_{i},e_{i})))^{\frac{1}{\gamma }} $$

其中超参数$\gamma$表示最相关的单词-图像区域对对最终相似度得分的影响程度。在一个batch的图像-文本对中,我们最大化正确对的相似度,最小化错误对的相似度:

$$ \mathcal{L}^{1}_{local} = -\sum_{i=1}^{M}\log P(E_{i}|V_{i}) $$

其中$P(E_{i}|V_{i}) = \exp (R(V_{i},E_{i})) / \sum_{j=1}^{M}\exp (R(V_{i},E_{j}))$,$M$为batchsize的大小

- 文本-图像相似性同理的,文本-图像的相似性可以形式化为:

$$ \mathcal{L}^{2}_{local} = -\sum_{i=1}^{M}\log P(V_{i}|E_{i}) $$

- 全局相似性以上我们计算了局部特征上的相似性得分,在全局区域,我们可以利用$\overline{v}$和$\overline{e}$的余弦距离作为全局相似度:

$$ \mathcal{L}_{global} = -\sum_{i=1}^{M}\log \frac{\exp ((\overline{v}^{T}\overline{e})/(\left \| \overline{v} \right \|\left \| \overline{e} \right \|))_{i}} {\sum_{j=1}^{M}\exp ((\overline{v}^{T}\overline{e})/(\left \| \overline{v} \right \|\left \| \overline{e} \right \|))_{i,j}} $$

综上,有:

$$ \mathcal{L}_{similarity} = \mathcal{L}_{global}+\mathcal{L}^{1}_{local}+\mathcal{L}^{2}_{local} $$

总结

我们期待该技术能应用于今年8月21日上线的阿里巴巴原创保护平台 (https://yc.alibaba.com) ,该平台旨在让在淘宝天猫首发创意手稿的商品图,经过原创性审核后就能获得阿里巴巴联合权威公证机构颁发的唯一“出生证”,破解原创商家创作难、抄袭易、确权维权成本高的难题。而根据文本来生成商品创意图像的技术,有望成为赋能商家用于商品设计的有效工具,并助力于用人工智能来理解商品创意。

附上算法效果图:

Reference

[1] Zhang H, Xu T, Li H. StackGAN: Text to Photo-Realistic Image Synthesis with Stacked Generative Adversarial Networks[C].

[2] Zhang H, Xu T, Li H, et al. Stackgan++: Realistic image synthesis with stacked generative adversarial networks[J]. [3] Xu T, Zhang P, Huang Q, et al. Attngan: Fine-grained text to image generation with attentional generative adversarial networks[C]. [4] Lee K H, Chen X, Hua G, et al. Stacked Cross Attention for Image-Text Matching[J].__同时推荐一下图灵实验室的另一个工作__:

转载地址:http://cofva.baihongyu.com/